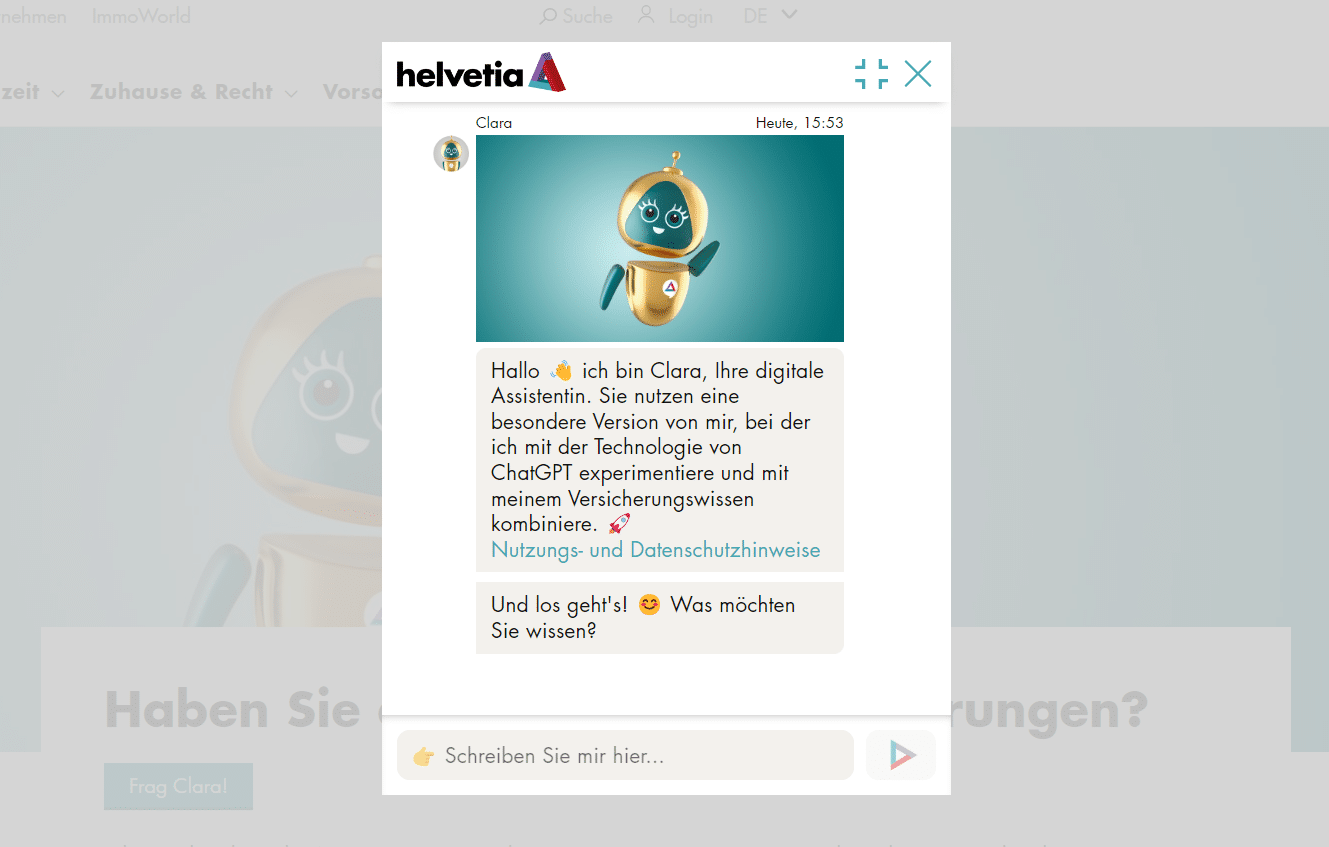

Ruft man neuerdings die Website der Helvetia Versicherung auf, prangt dort ein grosses Banner mit einem freundlich winkenden Roboter. Daneben ist zu lesen:

Erleben Sie Clara und ChatGPT im Live-Experiment. Unser Chatbot beantwortet auf Basis von ChatGPT Ihre Fragen zu Versicherungen, Vorsorge und Eigenheim. Probieren Sie es aus und chatten Sie jetzt mit Clara!

Etwas weiter unten sind einige Tipps zur Nutzung von Clara zu finden. Nebst den gängigen Vorschlägen, dass man sich kurz fassen soll, weist die Helvetia Versicherung auch darauf hin, dass es zu falschen Angaben kommen kann. Daher seien die Antworten von Clara und ChatGPT mit Vorsicht zu geniessen. Schliesslich betont die Helvetia, dass die Informationen keinesfalls rechtlich bindend seien und man sämtliche Haftung ablehne.

Daten werden in die USA übermittelt

Allein schon nach diesen Zeilen stellt sich die Frage, weshalb das Unternehmen auf einen Chatbot setzt, dessen Informationen nicht verlässlich sind. In den FAQ erklärt die Helvetia dies folgendermassen:

“Die künstliche Intelligenz erleichtert das Finden und Interpretieren der Informationen, die wir auf unserer Website zur Verfügung stellen. Dank des neuen Clara-Services können Sie sich also Fragen zu Versicherung und Vorsorge jederzeit und von überall beantworten lassen.

Darüber hinaus richten wir uns mit dem Experiment gezielt an KI-affine Personen, die Freude daran haben, Claras Fähigkeiten zu testen. Wir wollen unsere Kundinnen und Kunden inspirieren und gemeinsam mit ihnen Erfahrungen sammeln. Alle sind herzlich eingeladen, Claras neue Fähigkeiten zu testen.”

Ein Punkt, den die Helvetia aber aussen vor lässt, ist der Datenschutz. Durch die Einbindung von ChatGPT ist klar, dass die Eingaben der Personen, die Clara benutzten, an die Server von openAI übermittelt werden – und damit in die USA. Was dort im Detail mit diesen Daten geschieht, ist unklar. Was wir wissen ist, dass openAI solche Datensätze nutzt, um seine KI weiter zu verbessern.

Spätestens seit Italien ChatGPT wegen Daten- und Jugendschutzverletzungen gesperrt hat, ist das Thema Datenschutz im Zusammenhang mit künstlicher Intelligenz ein “Hot Topic”. Bei der Helvetia Versicherung geht man mit dieser Situation ziemlich pragmatisch um: Öffnet man das Chatfenster, verweist das Unternehmen auf die Nutzungs- und Datenschutzhinweise. Ein eindeutiger Hinweis, der den Nutzer:innen klarmacht, dass alle eingegebenen Daten in die USA an ein fremdes Unternehmen übermittelt werden, fehlt. Dies ist umso bedenklicher, da die Versicherung davon ausgehen muss, dass Nutzer:innen sensitive Daten wie Versicherungsnummern oder den Gesundheitszustand eingeben.

Schaut man sich schliesslich die Nutzungs- und Datenschutzhinweise an, wird klar: Selbst die Helvetia Versicherung rät von der Nutzung des Clara-Chatbots ab. Stattdessen soll man sich mit der persönlichen Beratung der Versicherung in Verbindung setzen.

In den Nutzungshinweisen ist dann auch zu lesen, dass Daten in die USA weitergeleitet und dort verarbeitet werden. Was das genau heisst, lässt die Helvetia unerwähnt und verweist stattdessen auf die Policies von openAI – wer allerdings kein Englisch kann, nützten diese wenig. Und selbst für Leute, die fliessend Englisch sprechen, dürfte der 80’000 Zeichen umfassende Rechtstext eine Herausforderung darstellen.

Helvetia schiebt Verantwortung auf die User

Für alle, die nicht möchten, dass ihre sensitiven Daten an openAI übermittelt werden, hat die Helvetia einen ziemlich offensichtlichen Rat:

“Wenn Sie keine personenbezogenen Daten an den Chatbot weitergeben möchten, können Sie dies tun, indem Sie keine personenbezogenen Daten in den Chatverlauf eingeben. Geben Sie also in Ihrer Unterhaltung am besten gar keine persönlichen Informationen ein, um komplett sicher zu sein.”

Immerhin bietet die Helvetia weitere Unterstützung bei Fragen zum Thema Datenschutz via E-Mail an und verweist auf seine eigenen Datenschutzbestimmungen. In diesen wird aber mit keinem Wort erwähnt, dass beim Chatbot ab sofort ChatGPT zum Einsatz kommt. Stattdessen ist darin eine Passage zu lesen, die Kund:innen ermutigen könnte, dem Chatbot sensitive Daten zu übermitteln:

“Bei gewissen Schaden- und Servicefällen fragt der Chatbot zur Identifikation nach persönlichen oder vertraglichen Angaben wie zum Beispiel Vorname, Name, Geburtsdatum oder Policen-Nummer. Wenn die betroffene Person in diesen Fällen eindeutig identifizierbar ist, kann die Unterhaltung mit dem Helvetia Chatbot fortgeführt werden.”

Clara liefert oft fehlerhafte Informationen

Wer sich trotzdem mit Clara unterhält, wird schnell feststellen, dass der Chatbot selbst mit künstlicher Intelligenz nicht viel zu bieten hat. Tatsächlich liefert er sogar regelmässig falsche Antworten, wie Steigerlegal.ch und tippinpoint.ch in eigenständigen Versuchen bewiesen haben. So beantwortete der Chatbot die Frage, wie hoch die BVG-Bezüge sind, wenn man 48 Jahre alt sei, damit, dass man mit 48 Jahren noch keine BVG-Beiträge bezahlen müsse und diese erst ab 25 Jahren relevant werden.

Ein offensichtlicher Fehler, den selbst Laien erkennen dürften. Das Risiko, dass ein User Clara nutzt, eine falsche Antwort bekommt und diese dann glaubt, dürfte auch Helvetia bewusst sein. Doch statt auf die Einführung von ChatGPT zu verzichten oder sie zumindest zu verschieben, versucht man sich mit teilweise gut versteckten Gefahrenhinweisen aus der Verantwortung zu ziehen.

Unter dem Strich ist das alles vor allem eines: Ein anschauliches Beispiel dafür, wie Unternehmen aus einem nicht digitalen Umfeld heutzutage krampfhaft versuchen, sich als innovativ zu verkaufen. Das Interesse der Kund:innen steht dabei nicht immer im Mittelpunkt.